Please select your location and preferred language where available.

GPUだけあっても“優秀な生成AI”にならない? 思考レベルを上げる“記憶”の秘密 半導体大手キオクシアが語る

何か質問すると、よどみなく答えてくれる生成AI。生成AIが物知りな理由は「AIが大量のデータを学習しているから」と説明されることが多い。AIに学習させ続ければ性能を飛躍的に高められる可能性があるが、現実はそう甘くない。

「高性能なGPUを入手すればいい」と思われがちだが、AIの性能を左右するのはGPUだけではない。ハードウェアの処理能力、AIに学習させるデータの量や質、AIがアウトプットした生成物のクオリティーとその検証方法――AIの開発や利用にはこうしたさまざまな要素を勘案する必要がある。

「ChatGPT」のようにクラウド側で処理するAIの利用から一歩進み、生成AIを自社導入する企業が増える今、生成AIの仕組みを改めて押さえておきたい。本稿では、国内半導体大手のキオクシアを取材。ストレージ製品を手掛けて30年以上となる“記憶”のプロに、生成AIの基礎を解説してもらう。

「生成AIはデータの集まり」 基礎が分かれば使い方が見えてくる

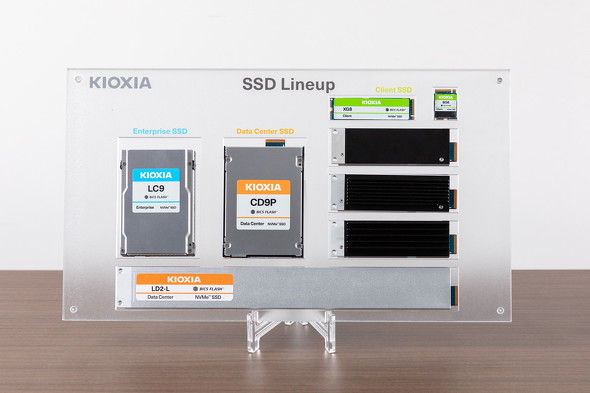

キオクシアは東芝の半導体メモリ事業を前身とし、フラッシュメモリやSSDなどを製造している。東芝時代の1987年に発明した「NAND型フラッシュメモリ」はデータの保存容量、書き込み速度、省電力性能などが高く評価され、デジタルカメラやスマートフォンなど幅広い電子機器に搭載されている。

「キオクシアは、生成AIの登場を好機と捉えています。AIは『データの集まり』です。AI技術を発展させるに当たってGPUに注目が集まっていますが、“AIの記憶”をつかさどるストレージも無視できない要素です」――キオクシアの福田浩一氏はこう語る。

AIとチャット形式で対話していると忘れがちだが、AIはデータでできている。生成AIの基となる大規模言語モデル(LLM)は、インターネットや企業内に蓄積された膨大な情報を使って作られている。Webサイトや書籍、論文、動画、画像など多様なデータを読み込み、知識をためると同時に、単語のつながり方や文脈のパターンを統計的に学習することで人間のような“賢い振る舞い”を生み出しているのだ。

Metaが2024年に公開したオープンソースLLM「Llama 3.1」は4050億パラメーターを誇る。ChatGPTに使われている「GPT-4」のパラメーター数は1兆を超えると推定されている。大ざっぱに言えば、パラメーター数が大きいほど高性能なLLMだ。Llama 3.1の学習に使ったデータ量は15兆トークンを超える。おおよそ10万トークンで書籍1冊分と言われるため、学習に使ったデータ量の大きさに驚かざるを得ない。

データを「学習」させて完成したLLM。私たちがAIと対話するとき、バックグラウンドでLLMは「推論」という処理をしている。ユーザーの指示に対して生成物を出力する際、学習した知識とパターンに基づいて答えを導き出す。

「学習と推論に必要な計算を担うのがGPUです。学習や推論にかかる時間を短縮したり、より大規模なモデルを作ったりするには高性能なGPUが欠かせません。こうした背景からGPUの需要が高まっています」

GPUの性能を向上させ続けたとしても「ビジネスに役立つ生成AI」が出来上がるとは限らない。AIが物知りなのは、膨大な学習データの中から適切な答えを導き出しているからだ。裏を返せば、学習していないことは答えられない。汎用(はんよう)的なAIに「当社の就業規則は?」と聞いても正しい答えは返ってこないし、2024年に作られたLLMに2025年の国際情勢や経済動向を尋ねても最新情報は答えられないのだ。

この課題の解決策として「RAG」(検索拡張生成)という技術が浸透し始めている。推論時に外部ソースを参照することで、LLMが学習していない企業独自のデータや最新情報を補完するものだ。社内規定を参照させて「自社専用AIチャットbot」を作ったり、特許情報や法律を集めたデータソースを用意して「法務AI」を構築したりできる。

さらに、回答精度をより高めるプロンプト手法「Chain-of-Thought」(思考の連鎖)も登場している。生成AIは複雑なタスクを苦手とする傾向があるため、1つのタスクを複数のステップに分割して段階的に推論させることで適切な出力結果を得るものだ。

AIが変えるストレージ市場の勢力図

「AIの学習や推論、RAG、どれを取ってもポイントになるのはデータです。AIの“頭脳”がGPUだとすれば、頭の回転がいくら速くても、知識がなければ優れた思考は生まれないでしょう。思考の材料となるデータを取得して保存し、必要なときに素早く引き出せる“記憶力”がAIの応答精度や回答の質を左右します。記憶力の役目を担うのがストレージです」

AIの性能は学習データの量と質に大きく依存する。Llama 3.1のように15兆トークンのデータを集めたとしても、それをどのように保管し、利用するかが課題だ。これまでデータセンターのストレージはHDDを採用するケースが多かった。HDDは大容量かつ安価のためコストパフォーマンスが優れておりストレージ製品の主力だったが、AI時代のニーズに応え切れていないと福田氏は説明する。

「HDDは磁気ディスクを物理的に回転させてデータを読み書きするため、データへのアクセス速度に限界があります。GPUが求めるデータ供給スピードに追い付けないのです。そこでAI基盤のストレージにSSDを採用する企業が増えています」

HDDは、記録された順序に沿ってデータを読み取るレコード盤のようなイメージだ。SSDはデータを電子的に記録するため、データが格納されている位置に直接アクセスする「ランダムリード」の性能が高い。福田氏は「価格はSSDの方が1桁高いのですが、データの読み込み性能はSSDの方が約1万倍も速いケースがあります」と話す。

「高性能GPUサーバの価格は1台で数百万円から数千万円にもなります。データ供給の速度が遅いと『データが送られてこないから計算できない』という事態になり、高価なGPUの能力を生かせません。データ回りのボトルネックを解消し、GPUを遊ばせることなく性能を100%引き出すためにSSDを選ぶのが英断と言えるでしょう」

さらに、電気代やメンテナンス費用などを含めたTCO(総保有コスト)を見るとSSDとHDDの差は縮まっているという。SSDは、HDDに比べて消費電力が小さく、故障率も低い。同じ容量で比べるとSSDの方が小型化できるため、省スペース化にもつながる。この点でも、SSDが有力な選択肢になるのだ。

NVIDIAからの挑戦状 「1億IOPSのSSD」に挑む

AI向け半導体の巨人であるNVIDIAもストレージの重要性を強く認識している。同社は2024年末ごろから、次世代のAIシステムを構成するSSDの姿を提示した。その要求はストレージ業界にとって衝撃的なものだったと福田氏は振り返る。

「NVIDIAが提示した要件は、SSDのランダムリード性能を現在の1桁上に引き上げてほしいというものでした。1秒当たりの読み書き回数を示す指標『IOPS』(Input Output Per Second)で、1000万IOPS台から1億IOPSにするという意味です。私たちストレージ開発者にとって極めて挑戦的な目標です」

これに対してキオクシアは、2025年6月の経営方針説明会で1000万IOPSを超える「Super High IOPS SSD」のコンセプトを発表。同社の横塚賢志氏(常務執行役員 SSD事業部長)は、AIを支える今までにないSSDとして「2026年後半にサンプル出荷を開始する」としている。

キオクシアは、長年研究を続けているフラッシュメモリ「XL-FLASH」を応用することでSuper High IOPS SSDの早期実現を見据えている。XL-FLASHは、データの書き込み/読み出しにおける遅延を大幅に低減したフラッシュメモリだ。

「AI活用の流れでランダムリードに注目が集まり、今までは真価を発揮できなかった技術を生かせるフェーズが来ました。1億IOPSのSSD開発に自信があるのは、XL-FLASHという技術を持っているからです」

AIの課題をストレージで解決 ハードウェアにこだわらない姿勢

キオクシアの挑戦はハードウェアにとどまらない。同社は「KIOXIA AiSAQ™」(アイザック/以下、AiSAQ)というデータ探索ソフトウェアをオープンソースで公開し、RAGで用いられる「ベクトルデータベース」の高度な活用を後押ししている。

ベクトルデータベースは、単語や文章といったデータの意味や文脈を「ベクトル」と呼ばれる数値の集合に変換して格納する。ベクトルデータベースを用意することで、キーワード検索の結果だけでは分からない「関連性や類似性が高いデータ」を高速に探せる。例えば「読む」という語句に対して「本、新聞、手紙」などを導くことができ、関連性が低い「ワインを読む」などの文章は生成されにくくなる。RAGで外部情報を参照する際の仕組みとして利用が広がっている。

ベクトルデータベースは「DRAM」(Dynamic Random Access Memory)というメモリで取り扱うことが多い。DRAMはデータを非常に高速に読み書きできるため、AIによる回答のようにリアルタイム性が求められる処理に向いている。しかし高価な上に容量が少なく、RAG市場の拡大を阻害する要因となりうる。

「ベクトルデータベースをSSDに移すことで、DRAMよりも大規模なデータを扱えるようにしようと開発したのがAiSAQです。AIの発展に貢献することはもちろん、AiSAQの開発を通じて“AI研究の最前線”で何が課題になっているかを理解したいという思いがあります」

AiSAQの開発を通してパートナー企業との会話が生まれ、ビジネス現場のリアルな悩みが見えてきたという。日々更新されるデータをいかに効率的にベクトルデータベースに反映させるか、多数のユーザーによる同時アクセスをどう処理するか、といった課題だ。

「現場の課題を深く理解することで、どのような性能を持つSSDが求められるのかが見えてきます。その知見をハードウェア開発にフィードバックする。このサイクルが、私たちを強くしています」

手探り状態のAI開発 「先頭を走りたい」

あるとき、福田氏は「AIが発展する中でSSDはどうなるか」という問いをハイパースケーラーに質問したという。するとAI開発の先端にいる彼らから返ってきた答えは「私たちも分からない。逆に教えてほしい」というものだったそうだ。

「ハイパースケーラーも手探りの状態です。私たちは自ら課題解決の議論に参加し、道筋を見つけ出す先頭を走りたいと考えています。NVIDIAからの挑戦的な要求も、私たちにとっては絶好の機会なのです」

生成AIブームにおいてGPUという華やかな主役が目立っている。しかしAIの性能を裏で支える“記憶”の重要性が高まっている中、ストレージという存在が表舞台に立つまでにそう時間はかからないだろう。そのとき、キオクシアの挑戦が実を結ぶはずだ。

記載されている社名・商品名・サービス名などは、それぞれ各社が商標として使用している場合があります。

転載元:ITmedia NEWS

ITmedia NEWS 2025年8月8日掲載記事より転載

本記事はITmedia NEWSより許諾を得て掲載しています。